はじめまして!さかなちゃんです!

「競馬予想AIモデルを自力で作ってみたい!」「予想を自動化させたい!」

前回の記事では、競馬予想モデルにおける「特徴量の作成」の重要性とその具体的な手法について解説しました。

特徴量を適切に設計することで、モデルがより正確な予測を行えるようになります。

今回のテーマは「モデルの作成と評価」です。

特徴量を基に予測モデルを構築し、その性能を評価することで、予測精度を最大化するプロセスを詳しく紹介します。

このステップは、競馬予想モデルの成功に欠かせない重要な段階であり、最適なモデルを選び出すための鍵となります。

- データサイエンスの分野に興味がある!

- 競馬予想を自動化させたい!

- 競馬やプログラミングに興味がある!

- 競馬予測モデルの作り方をざっくり知りたい!

- 競馬予想のためのモデルの作り方を知りたい!

①モデルの選定

どの機械学習モデルを選ぶかによって、前処理も変わります!

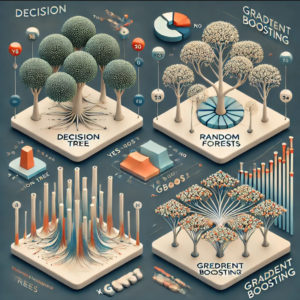

決定木は、データを条件に従って分岐させ、最終的に予測結果を導くシンプルなアルゴリズムです。

競馬予想においても、特定の条件下でどの馬が有利かを視覚的に理解しやすい特徴があります。

しかし、決定木は単純な構造ゆえに過剰適合しやすい欠点があります。

これを補うために、ランダムフォレストが用いられることが多いです。

ランダムフォレストは、複数の決定木を使って多数決で最終予測を行うアンサンブル手法で、予測精度が高く、過剰適合を抑える効果があります。

計算コストはやや高くなりますが、その分精度が向上するため、競馬予想においても多用されます。

XGBoostは、勾配ブースティングアルゴリズムの一種で、予測精度が非常に高いことから、競馬予想モデルにも適しています。

XGBoostは、弱い予測器(通常は決定木)を連続して学習させ、予測誤差を修正することでモデルの精度を向上させます。

この手法は、大規模なデータセットや複雑な特徴量を扱う際に特に効果的です。

ただし、計算コストが高く、適切なハイパーパラメータの設定が必要なため、経験と知識が求められます。

競馬のように複雑な要素が絡む予測問題では、その精度の高さが大きな強みとなります。

モデルの選定は、予測精度だけでなく、計算コストや解釈性にも大きな影響を与えます。

例えば、XGBoostやランダムフォレストは高精度な予測が期待できますが、計算コストが高くなりがちです。

一方で、ロジスティック回帰はシンプルで計算負荷が低いものの、複雑なパターンの予測には向いていない場合があります。

競馬予想モデルの目的やデータの特性に応じて、適切なアルゴリズムを選定することが、成功への鍵となります。

②モデルの構築

いよいよ予想モデルの作成です!

モデルを構築する前に、まずデータをトレーニングデータとテストデータに分割することが重要です。

これにより、モデルの性能を評価し、過剰適合を防ぐことができます。PythonのScikit-learnライブラリを使って、データを簡単に分割できます。

以下のコードは、データを80%のトレーニングデータと20%のテストデータに分割する例です。

from sklearn.model_selection import train_test_split

# 特徴量とターゲット変数を定義

X = race_data.drop(columns=['target'])

y = race_data['target']

# トレーニングデータとテストデータに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)このコードでは、train_test_split関数を使用してデータを分割しています。

random_stateを設定することで、データ分割の再現性を保つことができます。

Scikit-learnは、多くの機械学習アルゴリズムを簡単に実装できる便利なライブラリです。ここでは、ランダムフォレストを使ったモデル構築の例を紹介します。

from sklearn.ensemble import RandomForestClassifier

# ランダムフォレストモデルを構築

model = RandomForestClassifier(n_estimators=100, random_state=42)

# モデルをトレーニング

model.fit(X_train, y_train)

# テストデータで予測を行う

y_pred = model.predict(X_test)このコードでは、RandomForestClassifierを用いてランダムフォレストモデルを作成し、トレーニングデータで学習させています。

n_estimatorsは決定木の数を指定し、random_stateで再現性を確保しています。

学習が完了したら、テストデータに対して予測を行い、モデルの性能を評価します。

XGBoostは、勾配ブースティングを用いた高性能なアルゴリズムで、特に複雑なデータセットに適しています。

以下は、XGBoostを用いたモデル構築の例です。

import xgboost as xgb

# データをDMatrix形式に変換

dtrain = xgb.DMatrix(X_train, label=y_train)

dtest = xgb.DMatrix(X_test, label=y_test)

# ハイパーパラメータの設定

params = {

'max_depth': 6,

'eta': 0.3,

'objective': 'binary:logistic',

'eval_metric': 'logloss'

}

# モデルをトレーニング

model = xgb.train(params, dtrain, num_boost_round=100)

# テストデータで予測を行う

y_pred = model.predict(dtest)

このコードでは、XGBoostを使用してモデルを構築しています。

DMatrix形式にデータを変換することで、計算を効率化しています。

params辞書でハイパーパラメータを設定し、train関数でモデルを学習させています。

XGBoostは非常に柔軟で、複雑なデータにも対応できるため、競馬予想モデルにおいて高い精度が期待できます。

これらの手順に従ってモデルを構築し、適切なデータ分割とハイパーパラメータの設定を行うことで、競馬予想モデルの精度を最大化することが可能です。

③モデルの評価

作っておしまい!ではなく、評価をすることでさらに改良できます。

競馬予想モデルを評価する際には、複数の指標を使用してモデルの性能を総合的に判断することが重要です。

一般的な評価指標には、正解率、AUCスコア、F1スコアがあります。

正解率は、全体の予測に対する正解の割合を示しますが、クラス不均衡がある場合には限界があります。

AUCスコア(ROC曲線の下の面積)は、モデルがどれだけ良くクラスを区別できるかを示す指標で、特に二値分類問題で広く使用されます。

F1スコアは、精度と再現率の調和平均で、予測精度とカバー率のバランスを評価するために有効です。

これらの指標を組み合わせて評価することで、モデルの強みと弱点をより深く理解することができます。

予測モデルの評価には、データを分割して繰り返しテストを行う方法が有効です。

ホールドアウト法では、データセットをトレーニングセットとテストセットに分け、テストセットでモデルの性能を評価します。

これは簡単で計算コストも低いですが、分割方法に依存するため、評価結果が偏る可能性があります。

交差検証(クロスバリデーション)は、この問題を解決するための手法で、データを複数の部分に分割し、それぞれをテストセットとしてモデルを評価します。

例えば、k-分割交差検証(k-fold cross-validation)では、データをk個の部分に分け、各部分をテストセットとして使用し、k回の評価結果の平均を取ります。

これにより、より信頼性の高い評価が可能となります。

モデル評価の結果を基に、モデルの改善を図ることが次のステップです。

評価指標が期待に満たない場合、いくつかのアプローチでモデルの強化を試みることができます。

例えば、ハイパーパラメータのチューニングを行い、モデルの学習パフォーマンスを最適化することが考えられます。

また、特徴量選択を再検討し、重要度の低い特徴量を削除することでモデルの精度を向上させることも可能です。

さらに、アンサンブル学習を用いて複数のモデルを組み合わせることで、予測精度を高めることができます。

評価プロセスはモデル開発の中核であり、継続的な評価と改善を繰り返すことで、最適な競馬予想モデルを構築することができます。

④モデルの改善と最適化

モデル改良の方法についてもう少し詳しく見てみましょう!

モデルの評価結果に基づいて、パフォーマンスを向上させるために最も効果的な手法の一つがハイパーパラメータのチューニングです。

ハイパーパラメータとは、モデルの構造や学習プロセスに影響を与えるパラメータで、モデルのトレーニング前に設定します。

例えば、ランダムフォレストでは、決定木の数や木の深さがハイパーパラメータに該当します。

Grid SearchやRandom Searchなどの手法を用いて、さまざまなパラメータの組み合わせを試し、最適な設定を見つけることが可能です。

また、より効率的な方法として、Bayesian Optimizationを使用して探索範囲を狭めながら最適なパラメータを見つけることも有効です。

評価結果をもとに、モデルに使用する特徴量を再選定することも重要です。

特徴量が多すぎると、モデルが複雑になり過ぎ、過剰適合を引き起こすリスクがあります。

これを防ぐために、フィーチャーインポータンスやL1正則化などを利用して、重要度の低い特徴量を削除します。

また、新たな特徴量を作成してモデルに追加することも、性能向上の一助となります。

たとえば、既存の特徴量を組み合わせて新しい特徴量を作成する、あるいは非線形な変換を適用して複雑なパターンを捉えやすくするなど、特徴量エンジニアリングの手法を駆使することで、モデルの予測精度をさらに高めることができます。

アンサンブル学習は、複数のモデルを組み合わせて予測を行う手法で、個々のモデルの弱点を補い合うことで、より高い予測精度を実現します。

例えば、異なるアルゴリズムを用いたモデルを組み合わせるスタッキングや、同一アルゴリズムを異なるパラメータで学習させたモデルを平均化するブレンディングなどがあります。

アンサンブル学習は、単一のモデルに比べて過剰適合のリスクを減らし、汎化性能を向上させる効果があります。

ただし、アンサンブルを構築する際には、各モデルのバランスや組み合わせの方法に注意が必要です。

また、モデルの解釈性が低下する可能性もあるため、適切な解釈ツールを使用してモデルの挙動を理解しやすくする工夫が求められます。

モデルの改善と最適化は、競馬予想モデルの精度を最大化するための重要なステップです。

ハイパーパラメータのチューニング、特徴量の再選定、アンサンブル学習を組み合わせることで、より強力で信頼性の高いモデルを構築することができます。

また、過剰適合を防ぎながら、モデルの解釈性を維持する工夫も忘れずに行うことが、実際の競馬予想で成果を上げるために不可欠です。

⑤実践例とケーススタディ

まず、過去のレースデータを読み込み、特徴量を作成し、ランダムフォレストモデルを構築します。

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import accuracy_score, roc_auc_score, f1_score

# 過去のレースデータを読み込み

race_data = pd.read_csv('race_results.csv')

# 特徴量とターゲット変数を定義(例: 勝利したかどうかをターゲットとする)

X = race_data[['horse_past_win_rate', 'jockey_win_rate', 'course_experience', 'weather_condition']]

y = race_data['win']

# データをトレーニングデータとテストデータに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# ランダムフォレストモデルを構築

model = RandomForestClassifier(n_estimators=100, random_state=42)

model.fit(X_train, y_train)

# テストデータで予測を行う

y_pred = model.predict(X_test)構築したモデルの性能を評価するために、正解率、AUCスコア、F1スコアを計算します。

# モデルの評価

accuracy = accuracy_score(y_test, y_pred)

auc = roc_auc_score(y_test, model.predict_proba(X_test)[:, 1])

f1 = f1_score(y_test, y_pred)

print(f"Accuracy: {accuracy:.2f}")

print(f"AUC Score: {auc:.2f}")

print(f"F1 Score: {f1:.2f}")次にモデルの改善です。

ハイパーパラメータのチューニングを行い、モデルのパフォーマンスを向上させます。GridSearchCVを使用して最適なパラメータを見つけます。

from sklearn.model_selection import GridSearchCV

# ハイパーパラメータの候補を設定

param_grid = {

'n_estimators': [100, 200, 300],

'max_depth': [10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# グリッドサーチで最適なパラメータを探索

grid_search = GridSearchCV(estimator=model, param_grid=param_grid, cv=5, scoring='roc_auc', n_jobs=-1)

grid_search.fit(X_train, y_train)

# 最適なパラメータを取得

best_params = grid_search.best_params_

print(f"Best Parameters: {best_params}")

# 最適なパラメータでモデルを再構築

best_model = grid_search.best_estimator_

# 改善後のモデルで再評価

y_pred_best = best_model.predict(X_test)

accuracy_best = accuracy_score(y_test, y_pred_best)

auc_best = roc_auc_score(y_test, best_model.predict_proba(X_test)[:, 1])

f1_best = f1_score(y_test, y_pred_best)

print(f"Improved Accuracy: {accuracy_best:.2f}")

print(f"Improved AUC Score: {auc_best:.2f}")

print(f"Improved F1 Score: {f1_best:.2f}")このように、モデルの構築から評価、ハイパーパラメータのチューニングを経て、モデルの予測精度を向上させることができます。

最終的に得られたモデルを用いて実際の競馬予想を行い、どの馬が勝つかを高精度で予測することが可能となります。

このプロセスを繰り返し改善することで、実際の競馬での予測精度を高め、収益を上げることが期待できます。

まとめ

それでは、今回の内容をおさらいします。

- モデルの作成と評価は、競馬予想モデルの成功の鍵

- 継続的な改善が予測精度を向上させる

- 次回は「予測の自動化と実運用」をテーマに解説予定

今回のブログでは、「モデルの作成と評価」が競馬予想モデルの成功に不可欠なステップであることを解説しました。

適切なモデルの選定、構築、評価を通じて、予測精度を最大化し、実際の競馬予想での成功率を高めることが可能です。

次回は、予測の自動化と実運用に焦点を当て、構築したモデルをどのようにして実際の競馬予想に活用するかについて詳しく解説します。

モデルの精度と実用性を向上させるために、継続的な改善と調整が必要であることを常に意識しましょう!

うまサイエンス

うまサイエンス